Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- Kubernetes

- golang

- Rag

- APM

- LLM

- CKA

- CloudWatch

- 공부

- kotlin

- MySQL

- 바이브코딩

- kotlin coroutine

- CKA 기출문제

- aws

- Spring

- AI

- PETERICA

- minikube

- Linux

- 티스토리챌린지

- Java

- 코틀린 코루틴의 정석

- SRE

- 정보처리기사 실기 기출문제

- tucker의 go 언어 프로그래밍

- Pinpoint

- go

- 오블완

- 기록으로 실력을 쌓자

- AWS EKS

Archives

- Today

- Total

피터의 개발이야기

[AI] Llama 3 로컬 설치하기 본문

반응형

ㅁ 들어가며

ㅇ Llama 3.1 모듈을 로컬에 설치하고 LM Studio를 통해 로컬에서 사용하는 방법을 정리하였다.

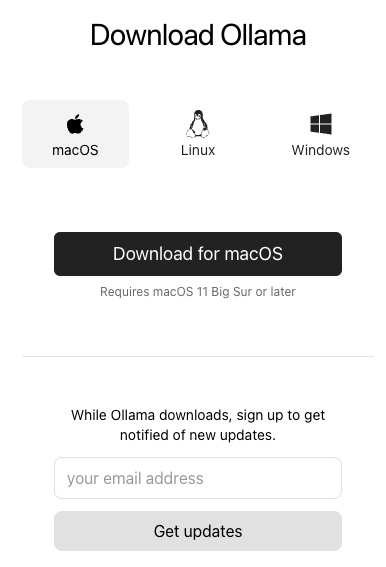

ㅁ Download Ollama

ㅇ Ollama를 다운받기 위해 이곳으로 이동한다.

ㅇ 다운로드 후 압축을 해제하면 앱이 생성되는데, 이 앱을 실행하였다.

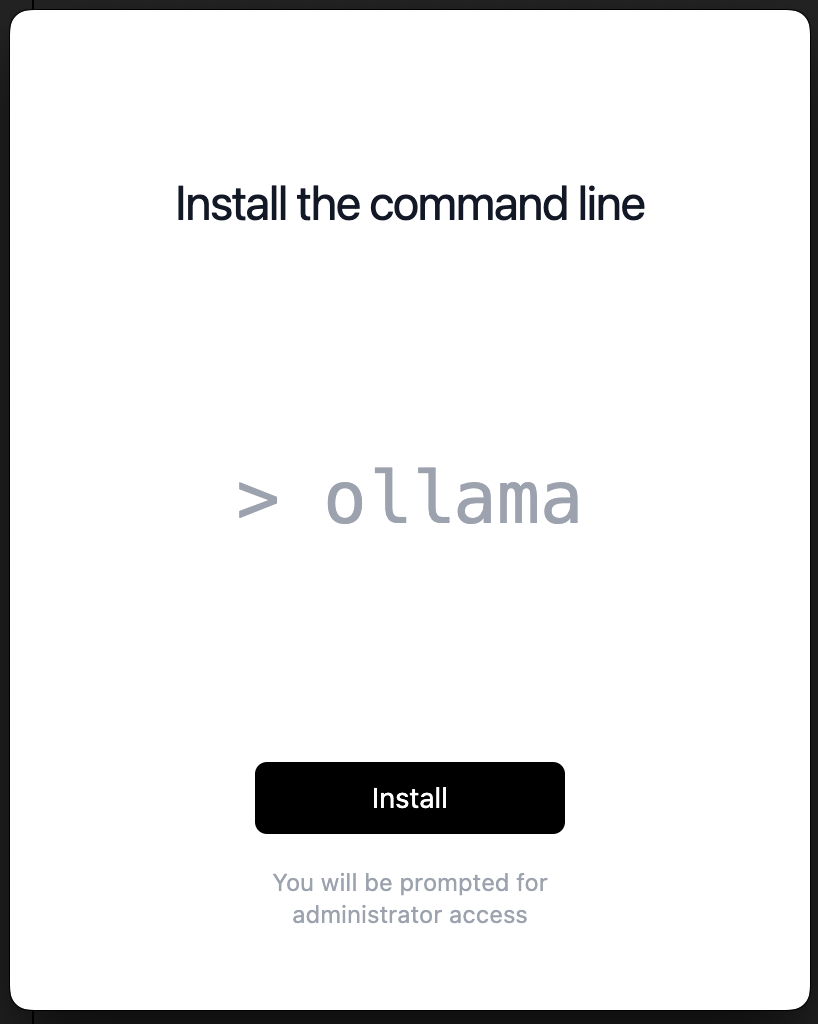

ㅇ Coomand line 툴을 설치한다.

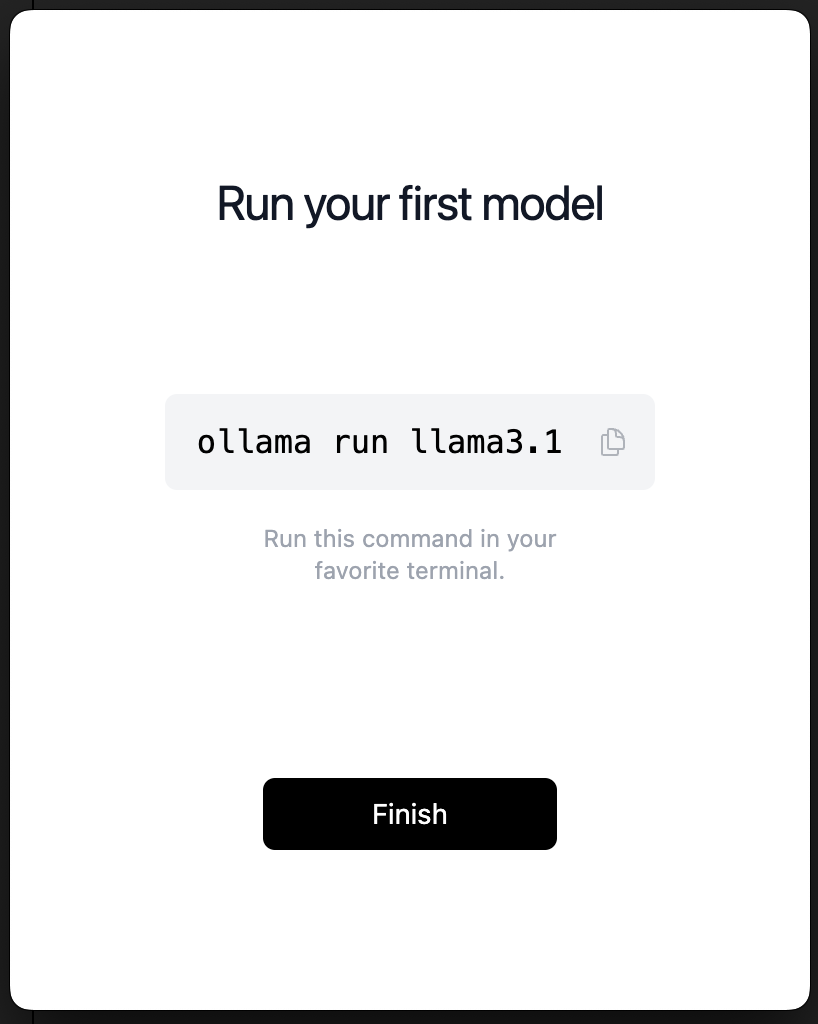

ㅁ llama3.1 run

$ ollama run llama3.1ㅇ 위 명령어를 터미널에서 실행하여 라마 모델을 실행한다.

ㅇ 설치를 하면 manifest를 다운받고 CLI로 명령할 수 있게 된다.

>>> 안녕

안녕하세요! 어떻게 지내세요?

>>> 파이썬으로 암호화 하는 코드 짜줘.

암호화를 하기 위한 다양한 알고리즘과 라이브러리들이 있습니다. 파이썬에서 일반적으로 사용되는

암호화 라이브러리는 `cryptography`와 `hashlib`입니다.

아래는 간단한 예시를 제공하는 코드입니다.

### symmetric-key encryption (_symmetric_key_encryption.py)

```python

from cryptography.hazmat.primitives import serialization

from cryptography.hazmat.primitives.asymmetric import rsa

from cryptography.hazmat.backends import default_backend

def generate_keys():

key = rsa.generate_private_key(

public_exponent=65537,

key_size=2048,

backend=default_backend()

)

~~~~~~~~~생략~~~~~~~~~ㅇ 안녕이라고 인사를 간단히 나누고 파이썬으로 암호화 하는 코드를 생성하도록 명령을 주었는데, 잘 작동하였다.

ㅁ 모듈 정보 및 다운로드 명령어

| Model | Parameters | Size | Download |

| Llama 3.1 | 8B | 4.7GB | ollama run llama3.1 |

| Llama 3.1 | 70B | 40GB | ollama run llama3.1:70b |

| Llama 3.1 | 405B | 231GB | ollama run llama3.1:405b |

| Phi 3 Mini | 3.8B | 2.3GB | ollama run phi3 |

| Phi 3 Medium | 14B | 7.9GB | ollama run phi3:medium |

| Gemma 2 | 2B | 1.6GB | ollama run gemma2:2b |

| Gemma 2 | 9B | 5.5GB | ollama run gemma2 |

| Gemma 2 | 27B | 16GB | ollama run gemma2:27b |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Moondream 2 | 1.4B | 829MB | ollama run moondream |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Solar | 10.7B | 6.1GB | ollama run solar |

ㅇ 다운로드 가능한 모듈의 목록이다.

ㅇ https://ollama.com/library

ㅁ Lama 3 모델 정보 확인

>>> /show info

Model

arch llama

parameters 8.0B

quantization Q4_0

context length 131072

embedding length 4096

Parameters

stop "<|start_header_id|>"

stop "<|end_header_id|>"

stop "<|eot_id|>"

License

LLAMA 3.1 COMMUNITY LICENSE AGREEMENT

Llama 3.1 Version Release Date: July 23, 2024

ㅁ OLLAMA 모델 삭제

# 명령어 확인

$ ollama --help

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

# 가동 모듈 확인

$ ollama ps

NAME ID SIZE PROCESSOR UNTIL

# 모듈 삭제

$ ollama rm llama3.1

deleted 'llama3.1'

# 모듈 리스트 확인

$ ollama list

NAME ID SIZE MODIFIEDㅇ LM Studio를 사용하기 위해서는 별도의 모듈을 설치해야하지 때문에 기존 모듈은 삭제하여 용량을 확보할 수 있다.

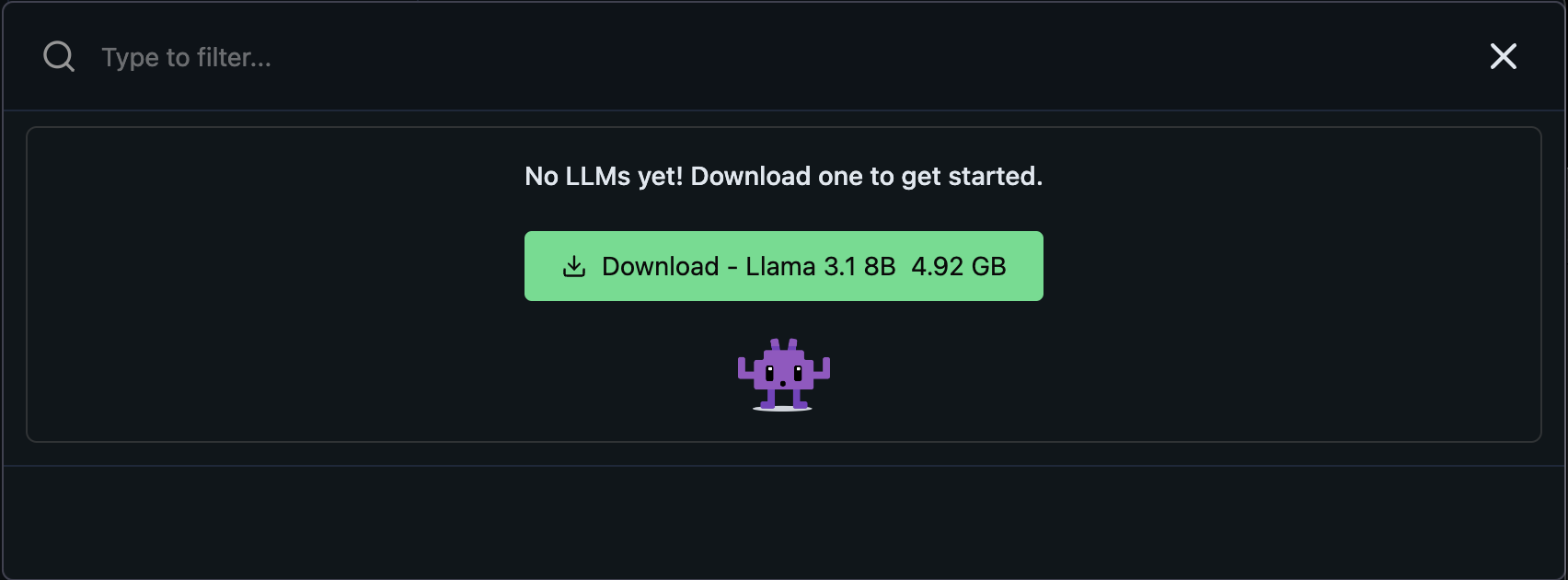

ㅁ LM Studio 설치

ㅇ LM Studio 설치 페이지 이동

ㅇ LM Studio를 설치한다.

# 최소 하드웨어/소프트웨어 요구 사항 #

- macOS 13.6 이상이 설치된 Apple Silicon Mac(M1/M2/M3)

- AVX2를 지원하는 프로세서가 장착된 Windows/Linux PC (일반적으로 최신 PC)

- RAM 16GB 이상, PC의 경우 6GB 이상의 VRAM을 권장

- 지원되는 NVIDIA/AMD GPU

ㅇ 초기 실행 화면이다.

ㅇ LM Studio에서 Lama 3을 사용하려면 별도로 lama모델을 설치해야한다.

ㅇ CLI cmd로 설치한 모델과는 별도이다.

ㅇ 모듈 설치가 완료되면, 오른쪽 로드 모듈 버튼을 클릭한다.

ㅁ 질문 테스트

명령 프롬프트

코틀린으로 null 값인 경우 기본 값으로 세팅하는 코드 작성해줘.

ㅁ 함께 보면 좋은 사이트

반응형

'AI > AI실험 | 기록' 카테고리의 다른 글

| [Cursor] Cursor 단축키 정리 (1) | 2025.08.26 |

|---|---|

| [AI] 컨텍스트 정리 (0) | 2025.08.26 |

| [AI] 복붙해서 쓰는 학습 세션 컨텍스트(교사 모드) (3) | 2025.08.26 |

| [AI] GTP4 Local LLM 사용해보기(GPT4ALL, Llama 3 8B, LocalDocs) (1) | 2024.09.13 |

| [AI] 구글 오픈 AI, 젬마(Gemma) Python으로 사용해 보기 (0) | 2024.02.25 |

Comments